HEXA BLOG

ヘキサブログ

新着記事

- HEXA BLOGいいモノづくり道2025.3.14 7周年記念グッズMemorial Call Gift …ということで セイからのメッセージを電話で伝えたいから始まったこの企画 7周年記念グッズMemorial Call Giftは絶賛受注…

- HEXA BLOGいいモノづくり道2025.3.13 社内ワークショップ お久しぶりです!東京スタジオエンバイロメントアーティストのたんのです。 お久しぶりですと言っても最後にブログを書いたのは入社して初めて書いたときだった気がするので、実に5年ほど経っているかと思われま…

- HEXA BLOGその他2024.11.8 2024年新人ブログデビュー④ UIアーティストを目指した経緯 始めまして。 2024年に大阪スタジオに入社した、新人UIアーティストのスエです。 今回は私がなぜUIアーティストを目指したのか、興味を持ったきっかけを お話ししたいと思います。 〈ゲーム…

- HEXA BLOG研修2024.11.7 2024新人ブログデビュー③ 新人ゲームデザイナーの一日 はじめまして! 2024年4月に大阪スタジオに入社して、 気づいたら7か月が経過していたゲームデザイナーの【42】です。 初めてのブログでは「新人ゲームデザイナーの一日」を紹介したいと思…

- HEXA BLOGその他2024.11.6 2024新人ブログデビュー② 朝のルーティン はじめまして! 今年の4月より入社しました、大阪スタジオ新人リギングアーティストのAkiです! 今回お話するテーマは『朝のルーティン』についてです。 いきなりですが、皆さんは朝が得意です…

- HEXA BLOGその他2024.11.5 2024新人ブログデビュー① 自然に浸る こんにちは! 2024年に大阪スタジオに入社しました、Environment ArtistのEZAです。 早速ですが、皆さん最近ネット環境に疲れていませんか? LINE,Inst…

- HEXA BLOGデザイン2024.7.25 NicOのタイトルロゴについて話す回 皆さんこんにちは、大阪デザイナーのじーつーです! ●これまでのブログ ・ドット絵~打つ回~ ・ドット絵~動かす回~ 7月に入り段々と暑さが牙をむいてきた今日この頃、皆さんは…

- HEXA BLOGいいモノづくり道2024.7.18 NicO・いってきますのお部屋・について NicO ・いってきますのお部屋・ シーズン1のプレイありがとうございました! 大阪開発の阿部です。 MakeSの時と同様にリリース直後に開発ブログを書きたかったのですが 盛大なネタバ…

- HEXA BLOGデザイン2024.6.28 なんでもやってみよう こんにちは!2DUIデザイナーのハマグチです。 ■前回までのブログ ・スキル分析【自分の得意分野を知ろう】 ・イラスト【連作イラストの制作】 ・中休み【らくがき&振り返り】 ・U…

- HEXA BLOG日記2024.1.9 明けましておめでとうございます。 明けましておめでとうございます。 松下です。 ヘキサドライブは、本日より本格始動となります。 皆様、年末年始は如何お過ごしでしたか? 新型コロナウイルスも以前より落ち着いてきて、徐々にコロ…

- HEXA BLOG日記2023.12.22 2023年ブログ納め こんにちは。 松下です。 ヘキサドライブでは、来週より有給取得奨励期間となり、 年明けの対応は、2024年1月9日(火)からとなります。 年末年始休業のお知らせ 本年も様々な事がありましたが…

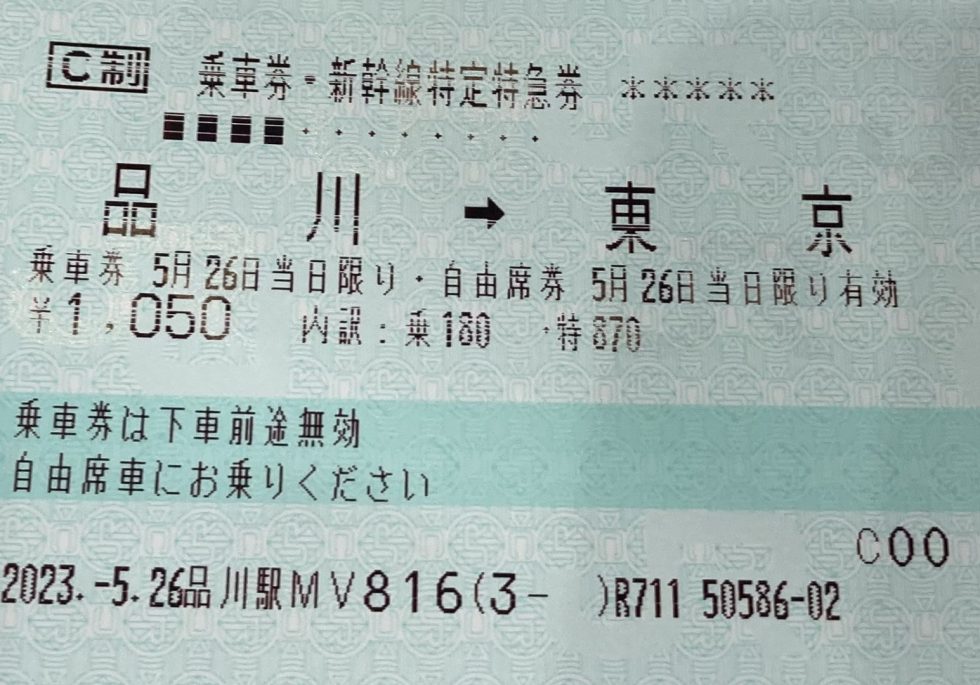

- HEXA BLOG日記2023.11.15 新人ブログデビュー⑨ 帰宅選手権 こんばんは。 2023年に東京スタジオに新卒入社したプログラマーの魚です。 皆さんは仕事が終わったあとの楽しみはありますか? 美味しいご飯を食べたり、やりたかったゲームをしたり、といった楽し…